機械学習プロジェクトでは、モデルの開発・検証を繰り返す中で、「どのハイパーパラメータが有効だったか」「結果を再現できるか」「チーム内でどう共有・比較するか」といった課題に直面します。

これらの課題を解決するために、Vertex AI Experimentsは強力な機能を提供しています。

本記事では、Google Cloudの「Professional Machine Learning Engineer」認定資格の試験対策教材に基づき、Vertex AI Experimentsを用いた実験トラッキングのベストプラクティスを体系的に解説します。

🔷 Vertex AI Experiments の基本的な役割

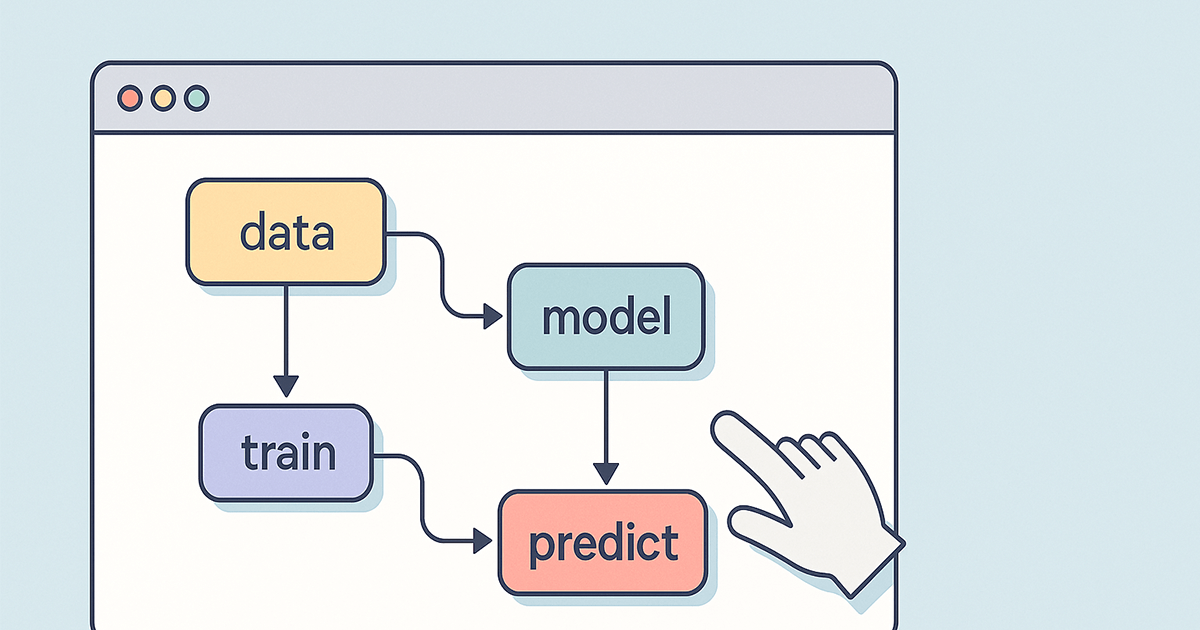

Vertex AI Experimentsは、機械学習の各トレーニング実行(Run)ごとのログを自動記録し、実験の履歴やメタデータを管理・比較するための仕組みです。

たとえば以下のような課題に対応できます:

- 実験の再現性を担保したい

- チームで成果や途中経過を共有したい

- 手動による記録ミスやログ忘れを防ぎたい

このような課題解決において、Vertex AI Experimentsは中心的な役割を果たします。

✅ ベストプラクティス:推奨される構成

| 機能・構成要素 | 推奨理由 |

|---|---|

| Vertex AI Experimentsを使用して各トレーニングを自動ログ化 | 再現性と一貫性を確保。各実験が体系的に保存・比較可能 |

| Vertex AI Pipelinesでワークフローを自動化 | トレーニング・評価・記録など一連の流れを自動化し、効率化とヒューマンエラーの低減に寄与 |

この2つの組み合わせにより、効率的かつ再現性のある実験環境が整います。

🔻 よくある誤解・非推奨な構成

| 非推奨な方法 | 理由 |

|---|---|

| Cloud StorageやCloud SQLに手動でログ保存 | 手動ログはエラーが発生しやすく、再現性や整合性に課題があるため。 |

| BigQueryへの保存 | データ格納には適しているが、実験トラッキングの最適解ではない。 |

| Apache Beamなどでのデータ前処理のみの活用 | データ前処理には有用だが、ログ化・トラッキングには寄与しない。 |

| LookerなどのBIツールでの可視化のみの活用 | 結果の可視化は可能だが、実験履歴そのものの管理には不十分。 |

| Pythonによるカスタムスクリプト | 柔軟性は高いが、Vertex AIとの統合性や運用の容易さに劣る。 |

📌 試験対策の観点で押さえるべきポイント(EXAM FOCUS)

| 観点 | 内容 |

|---|---|

| Vertex AI Experimentsの使用 | 実験の一貫したログ化、再現性、チームコラボレーションに不可欠 |

| Vertex AI Pipelinesとの組み合わせ | 実験全体のワークフローを自動化し、効率と信頼性を両立 |

| Model Monitoring / Model Registryの誤用 | これらはデプロイ後のモデル監視・保存用であり、学習中の実験トラッキングには不向き |

🛑 試験でひっかけられやすいポイント(CAUTION ALERT)

- Cloud Storage や Cloud SQLは保存には便利だが、実験トラッキングには不向き。

- Vertex AI Model MonitoringやModel Registryは「デプロイ後」が対象なので、試験では選ばないよう注意。

- Apache Beamなどの前処理ツールは、トラッキング目的には選択肢に入らない。

✒️ まとめ

Vertex AI Experimentsは、実験結果を「見える化」し、再現性を高め、チーム内での共有をスムーズにするための中核的な機能です。

試験対策としては、「自動ログ化」「パイプラインでの自動化」「Cloud Storageは避ける」といったポイントを押さえておきましょう。