機械学習エンジニアは、PII(個人識別情報)やPHI(保護対象保健情報)を含むデータを扱う際、プライバシー保護とデータユーティリティの両立が求められます。GDPRやHIPAAなどの規制遵守を前提としながら、以下の観点で技術的な対処が必要です。

✅ 1. 機密データの識別・マスキング

| ツール | 概要 | 該当手段 | 解説 |

|---|

| Cloud Data Loss Prevention (DLP) | PII/PHIの検出・分類・マスキング | ✅ 必須 | プライバシー保護規制対応に最適なツール |

- Cloud DLP は データの内容に基づいて敏感情報を検出・マスキング。

- 自動的にマスクやトークナイゼーションを実施し、元データを加工。

- GDPR、HIPAA対応に直結。

✅ 2. 差分プライバシー(Differential Privacy)

| 技術 | ツール | 特徴 | ユースケース |

|---|

| Differential Privacy | TensorFlow Privacy | データ全体の統計的傾向は維持しながら個人情報を秘匿 | モデル学習時のプライバシー保護に有効 |

- 学習データにノイズを加えて個別データを推測不能に。

- 機械学習モデルに組み込むことで、性能とプライバシーの両立が可能。

🚫 3. 不適切または補助的な手段(単独では不十分)

| 手段 | 状態 | 解説 |

|---|

| Google Cloud Dataflow | ❌ 不適 | 主にデータ処理に用いられ、マスキングや分類は不得意 |

| BigQuery での暗号化保存 | ❌ 不十分 | データを暗号化してもマスキングや匿名化の代替にはならない |

| Cloud IAMによるアクセス制御 | ⚠️ 補完的 | 必要だが、匿名化の代替にはならない |

🔔 注意喚起:

暗号化やアクセス制御だけでは、GDPRやHIPAAの「匿名化の要件」を満たさない。

✅ 4. 推奨されるベストプラクティス(GCP MLエンジニア向け)

| ステップ | 推奨ツール | 解説 |

|---|

| ① データの分類とマスキング | Cloud DLP | 最初の段階でPII/PHIを検出しマスキングすることでリーク防止 |

| ② 差分プライバシーの導入 | TensorFlow Privacy | モデル学習時のプライバシー維持を確保 |

| ③ アクセス制御 | Cloud IAM | 限定ユーザーにのみアクセスを許可(補完策) |

| ④ 保存時の暗号化 | BigQuery + Encryption | 安全なデータ保存に使用(匿名化ではない) |

📌 Exam Focus と Caution Alert

| EXAM FOCUS | 内容 |

|---|

| Cloud DLP | PII/PHI の検出・マスキングに必須 |

| TensorFlow Privacy | 学習データの差分プライバシー付与 |

| CAUTION ALERT | 内容 |

|---|

| Encryption ≠ Anonymization | 暗号化は匿名化の代替にならない |

| IAM alone is insufficient | アクセス制御だけでは規制遵守を満たせない |

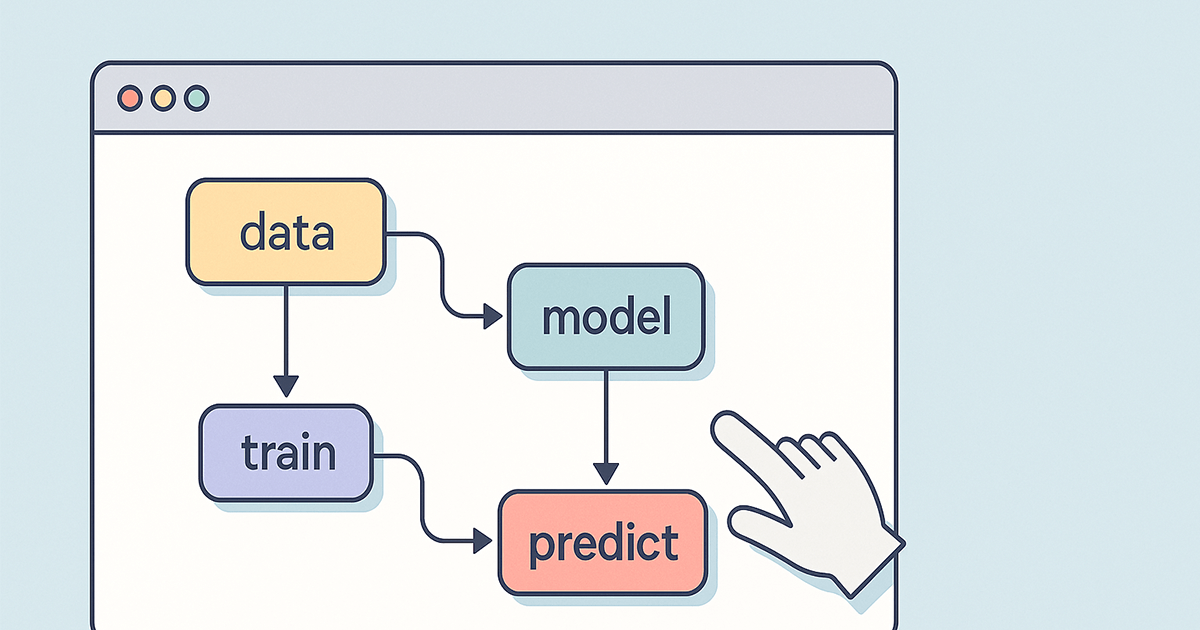

🎯 結論:試験・実務における対応フロー

flowchart TD

A[データ取得] --> B[Cloud DLPでPII/PHIを検出・マスキング]

B --> C[TensorFlow Privacyで差分プライバシー付与]

C --> D[BigQueryで暗号化保存]

C --> E[Cloud IAMでアクセス制限]

以上が、GCP Professional Machine Learning Engineer 資格で問われる「Handling Sensitive Data」に関する重要なポイントの整理です。プライバシー保護は単なる暗号化では不十分であり、DLPと差分プライバシーが必須の技術であることを強く意識しましょう。