~Vertex AI Workbench、Dataproc、TFX連携を中心に~

はじめに

GCP上でのJupyterノートブック環境の構築は、データサイエンティストやMLエンジニアがモデル開発・データ分析を行う上で不可欠です。本記事では、GCP Professional Machine Learning Engineer試験で問われる「Jupyter backend selection」に関する代表的なユースケースと、環境ごとの構成ポイントをまとめます。

1. Vertex AI Workbench を使った BigQuery 分析

ユースケース

- データサイエンティストが BigQuery上の大規模データ を Jupyter環境で分析 。

必要な構成変更

- ✅ Vertex AI Workbenchのインストール

- ✅ **

✅ 正しいpandas_gbqのimport文の使用** (誤ってpandasから読み込んでいるケースに注意)

不要な変更

- ❌ 認証設定はNotebook実行環境で自動付与される

- ❌ クエリ構文自体はBigQuery仕様に準拠していれば問題なし

試験対策ポイント

pandas_gbqはfrom pandas_gbq import read_gbqのように正確にインポートvaiw.display(df)のようなVertex AI Workbench固有関数の使用に慣れる

2. Dataproc を用いた Jupyter with Spark

ユースケース

- 分散処理が必要な大規模データ分析や、Spark MLlibを活用したモデル開発

必須構成

- ✅

--optional-components=ANACONDA,SPARK,JUPYTERのように

Jupyter および Spark をオプションコンポーネントとして追加する

- ✅ 単一ノード構成(

--single-node)でもテスト環境としては有効

試験対策ポイント

--image-versionによって使えるコンポーネントが制限される場合があるため、バージョン互換 も確認する

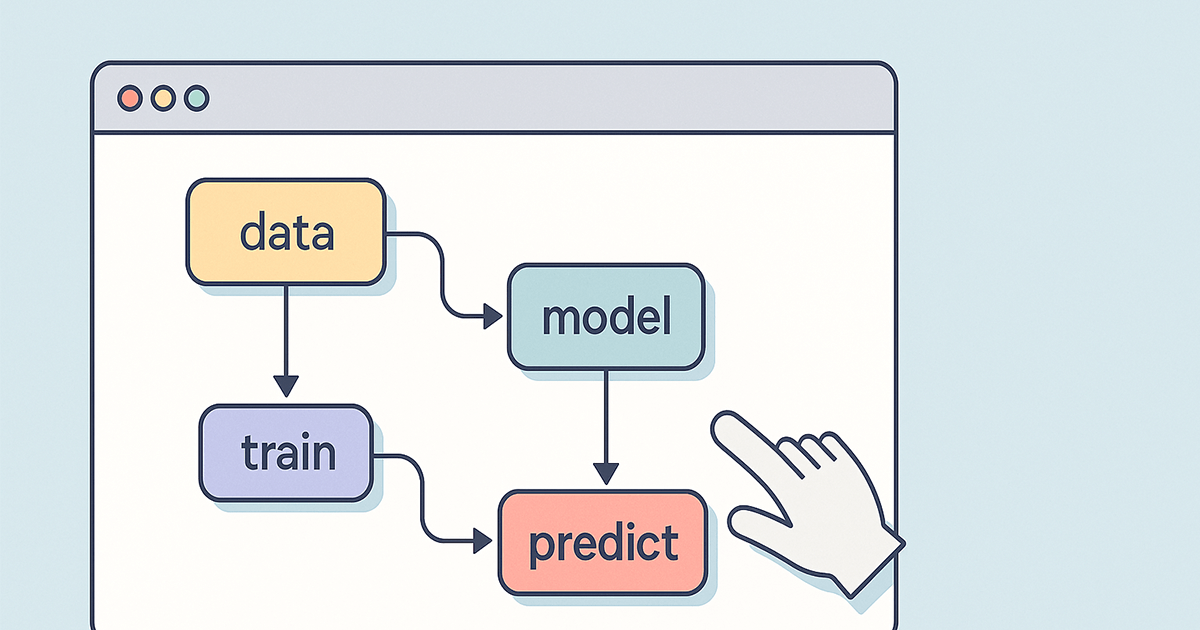

3. TensorFlow Extended (TFX) + Jupyter の統合

ユースケース

- MLパイプラインの定義・テスト をJupyter上で行い、TFXによるデプロイまで進める

構成の必須ポイント

- ✅

tfxモジュールの正確なimport(import tfx.orchestration.pipelineなど) - ✅

components=[]にてパイプライン構成要素(ExampleGen, Trainer等)を明示的に追加

注意点

- ❌

LocalDagRunner()はローカル実行用で問題なし - ❌ Cloud SQLとの接続(

metadata_path)は不要な場合が多い

4. DataprocでのBigQuery連携の最適化

ユースケース

- SQLでBigQueryからデータ抽出・整形を行い、DataprocのSpark処理と連携

構成変更ポイント

- ✅ SQLクエリの最適化 (不要なカラムの除外、絞り込みの明確化など)

- ✅ テーブル作成時のパーティショニング の追加でパフォーマンス改善

試験対策ポイント

CREATE TABLEの記述時にPARTITION BYを使うとクエリ高速化に有効

まとめ:Backend選定時の意思決定表

| 使用目的 | 推奨Backend | 主な特徴 | 試験で問われる設定ポイント |

|---|---|---|---|

| BigQuery分析 | Vertex AI Workbench | GUI付きJupyter、pandas_gbq連携 | vaiw.display(), pandas_gbq import |

| Spark分析 | Dataproc | 分散処理、スケーラブル | –optional-components へのSPARK/JUPYTER追加 |

| MLパイプライン | Vertex AI or local Jupyter + TFX | パイプライン開発・実験向け | 正しいTFX importとcomponents定義 |

| 大規模SQL前処理 | Dataproc + BigQuery | SQL最適化、Spark処理前段 | SQL最適化+パーティショニング |

試験対策アドバイス

- 構文エラーではなく構成ミスに注目!

各問題で問われるのは、多くの場合構文そのものより ライブラリのimport や 必要コンポーネントの指定漏れ 。

- 単一ノード vs 複数ノードの判断は問題文の文脈に依存 。

試験では「チームで使う」か「個人でローカルテスト」かを見極めるのがポイント。

- Vertex AIとDataprocの使い分け :

分析・探索的作業ならVertex AI、スケーラブル処理や本番デプロイを意識するならDataprocが主流。