✅ はじめに

Google CloudのDataflowは、Apache Beamを基盤としたフルマネージドのデータ処理サービスであり、ストリーミングデータやバッチデータの変換や集約をスケーラブルかつ効率的に行えます。

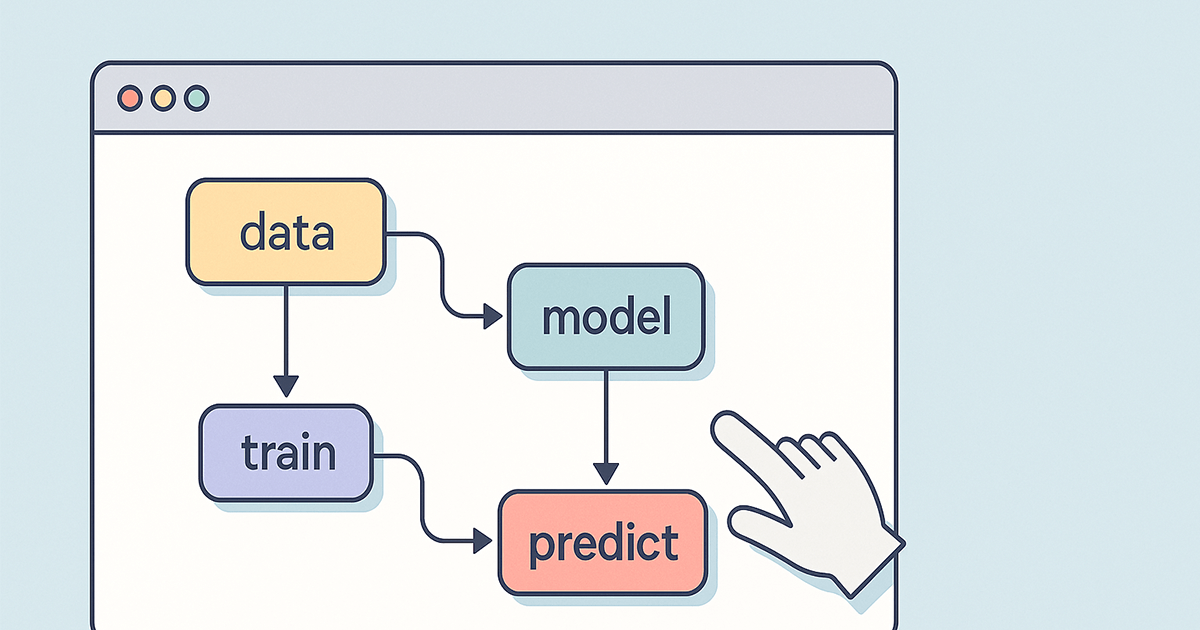

機械学習パイプライン、特にVertex AIを用いたモデル開発において、Dataflowはデータ前処理フェーズで重要な役割を果たします。大量の生データを、モデル学習に最適な形に変換・クリーニングし、またパイプラインのパフォーマンスを監視・最適化することで、学習効率や運用コストを大幅に改善できます。

本記事では、GCP認定MLエンジニア資格試験の出題範囲に沿って、Dataflowを活用したデータ前処理およびパイプライン最適化のベストプラクティスを体系的に解説します。

📂 Dataflow前処理の基本構成

1. Apache Beamによるデータ変換の設計

Dataflowでデータを変換・処理する際のコアとなるのがApache Beamです。Beamは、データパイプラインの変換処理(クリーニング、フィルタリング、集約など)をプログラムで記述するためのSDK(ソフトウェア開発キット)で、Dataflowはその実行エンジンとなります。

Apache Beamを使うことで、以下のような処理が可能です:

- 不要なデータの除去や正規化

- データのグループ化や集約処理(Combinerの活用)

- 時系列データに対するWindowingやTriggersによるリアルタイム処理

これにより、ストリーミングデータとバッチデータの両方に対して柔軟な変換処理が設計できるため、機械学習用のデータセットを最適な形で準備できます。

2. Dataflowパイプラインのモニタリングと最適化

データパイプラインは、一度構築したら終わりではなく、パフォーマンス監視と最適化が重要です。特に大量データを扱うMLパイプラインでは、処理のボトルネックやエラーを早期に検知し、コスト効率を高める必要があります。

そのための主な手法が以下です:

- Cloud Monitoringとの統合:

DataflowパイプラインをGoogle Cloud Monitoringと統合することで、リアルタイムのパフォーマンス指標(スループット、レイテンシ、ジョブ状態など)を可視化し、適切なアラート設定によって障害やパフォーマンス低下を早期に発見できます。 - Dataflowの組み込みメトリクス:

Dataflow自体が提供する詳細なメトリクス(CPU使用率、メモリ使用量、各ステージの処理件数など)を活用することで、パイプライン全体のボトルネック特定やエラー分析が行えます。

この情報をもとに、処理の最適化やリソースの調整を行うことで、コスト効率も改善できます。

📡 ストリーミングデータの前処理戦略

金融取引やIoTデバイスからのデータなど、リアルタイム性が求められる場面では、ストリーミングデータの前処理が必要になります。ここでの基本構成は以下です:

- Pub/Sub + Dataflow:

Pub/Subがデータのリアルタイムストリーミングを担い、Dataflowがそのデータを受け取って変換・集約などの処理を行います。これにより、低レイテンシで高スループットなデータ処理が実現します。 - Apache BeamのWindowing & Triggers:

ストリーミングデータは無限に流れ続けるため、一定期間や条件ごとにデータをまとめる仕組みが必要です。それがWindowingとTriggersです。

例えば、5分ごとにデータを集計する、一定量が溜まった時点で処理を開始するなど、リアルタイムでの柔軟なデータ処理を可能にします。

📊 バッチデータの前処理とパイプライン最適化

過去の履歴データや大量のトランザクションログを一括で処理する際には、バッチ処理が有効です。この場合、Dataflowの以下の機能がパフォーマンス最適化に役立ちます:

- Dataflow Shuffle:

シャッフル処理はデータの並べ替えやグルーピング時に発生しますが、大規模データではこれがボトルネックになることがあります。Dataflow Shuffleを有効化することで、シャッフルフェーズのパフォーマンスを向上させ、スケーラビリティが改善されます。 - Apache BeamのCombiner:

データの集約処理(合計、平均、カウントなど)を行う際に、Combinerを使うと、データ転送量が減少し、処理負荷を軽減できます。特に大規模なデータセットの集約処理には不可欠な最適化手法です。

🚨 試験対策で覚えておくべき注意点

| ポイント | 解説 |

|---|---|

| Cloud Storageでの中間データ保存は効率的ではない場合がある | データフロー中での中間結果保存には向いておらず、パフォーマンスやコストに悪影響を与える可能性がある。 |

| Autoscalingは万能ではない | 自動スケーリングは便利だが、レイテンシやスループット最適化には追加の工夫が必要。 |

| Cloud Composerはオーケストレーション用途 | ジョブのスケジューリングや依存管理には有効だが、パイプラインのパフォーマンス最適化には寄与しない。 |

| FlexRSはコスト最適化のみ | 処理のパフォーマンス向上や監視には関係なく、コストを抑える目的で使う。 |

| Cloud Functionsはイベント駆動型 | 定期的なパイプライン監視ではなく、イベント発生時にトリガーを実行する用途で使用。 |

📝 まとめ

Dataflowによるデータ前処理は、MLパイプラインの成功に不可欠です。

以下のベストプラクティスを押さえることで、試験対策にも実務にも役立つ理解が深まります。

| テーマ | ベストプラクティス |

|---|---|

| データ変換 | Apache Beamを使った柔軟な変換処理 |

| パイプライン監視 | Cloud MonitoringやDataflowのメトリクスを活用 |

| ストリーミング処理 | Pub/Sub + Dataflow、Windowing & Triggersによるリアルタイム処理 |

| バッチ処理最適化 | Dataflow ShuffleとCombinerによるパフォーマンス向上 |

EXAM FOCUS:

- Apache Beamでの変換処理と最適化手法(Combiner、Windowing、Triggers、Shuffle)

- Dataflowの監視方法(Cloud Monitoring、メトリクス)

- ストリーミング vs バッチ処理の違いと、それぞれの最適化アプローチ