Google Cloud の Vertex AI Workbench は、機械学習モデルの開発からデプロイ、運用までを一貫して行うための強力な統合開発環境です。本記事では、GCP認定プロフェッショナル機械学習エンジニア資格の教材から、「Vertex AI Workbench を用いたモデル開発」の要点を体系的に解説します。

1. データの取り込み:適切なAPIを選ぶ

モデル開発において、まず必要になるのは大量の学習データを効率よく取り込むことです。Vertex AI Workbench では、以下のAPIを使用して、データを直接ロードできます。

- BigQuery Storage API:PyTorchやsklearnなど、幅広いフレームワークで利用可能。BigQueryに格納された大規模データセットを高速に読み込む手段として推奨されています。

- TensorFlow Data API:TensorFlow専用の効率的なデータ読み込み手段。Cloud Storageとの連携に優れており、TensorFlowモデルでの利用に適しています。

- ※ JAXとの組み合わせでは非推奨 です。JAX向けにはBigQuery APIなど他の手段を使う必要があります。

2. データ前処理:Feature Storeではなく処理専用ツールを使う

データの前処理については、しばしば混乱が生じますが、Vertex AI Feature Store は前処理ツールではなく、特徴量管理のためのストアです。以下のような手段を使って、スケーラブルに処理を行うのが推奨されます。

- BigQuery:集計やフィルタリングなどの前処理に適していますが、ワークフローの自動化までは対応していません。

- Apache Beam:分散処理基盤として大規模な前処理タスクに活用できますが、フレームワーク依存性がある点に注意。

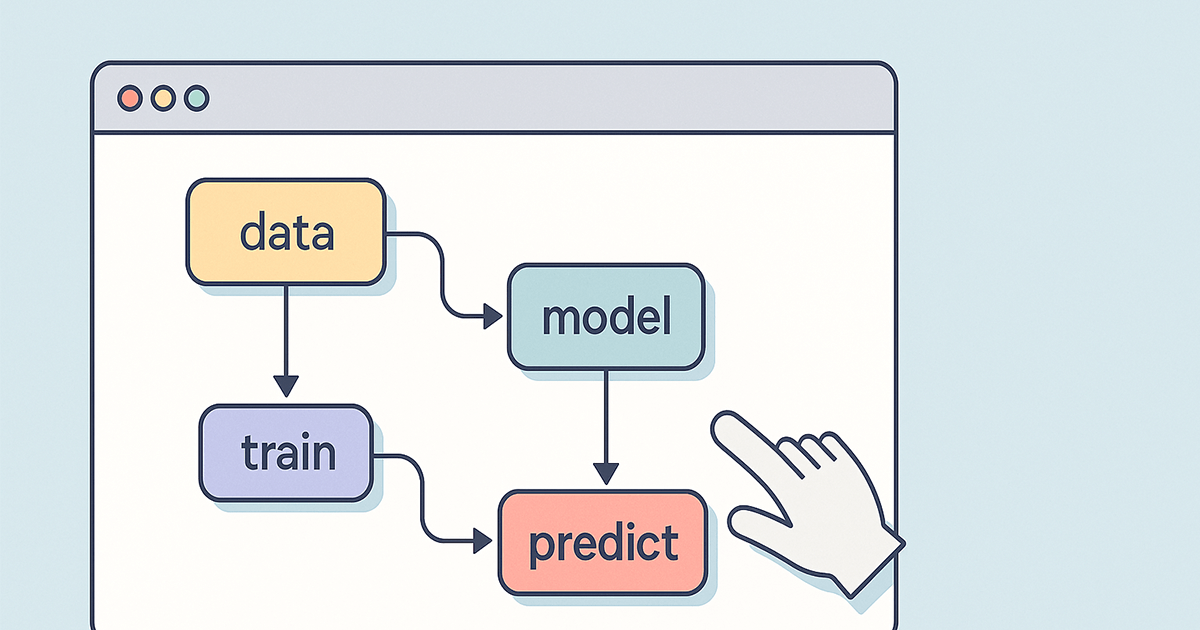

3. モデル学習と保存:Feature Storeへの直接保存は避ける

モデルの学習は、TensorFlow、PyTorch、sklearn、JAX など任意のフレームワークでVertex AI Workbench上で実行できます。学習後のモデルは、通常以下のように保存されます。

- Vertex AI Model Registry:モデルのバージョン管理や再利用の観点で最適な保存場所。

- Cloud Storage:一時的な保管場所や柔軟な用途に使われる。

- ❌ Vertex AI Feature Store に直接保存するのは非推奨。Feature Storeはあくまで特徴量の保存・提供のためのサービスです。

4. ワークフローの自動化:Vertex AI Pipelines が鍵

MLの各工程(データ取り込み、前処理、学習、デプロイ)をバラバラに実行すると、ミスや非効率が生じやすくなります。そこで活用すべきなのが Vertex AI Pipelines です。

- Vertex AI Pipelines を使うことで、全体のワークフローを自動化することが可能になります。

- 複数のMLフレームワーク(TensorFlow、PyTorch、sklearn、JAX)に対応し、再現性のあるパイプライン構築ができます。

5. モデルのデプロイと運用監視

学習済みモデルの利用やパフォーマンス監視にも、Vertex AIの各種サービスが有効です。

- Vertex AI Prediction:学習済みモデルをオンライン推論環境にデプロイする際に使用。

- Vertex AI Model Monitoring:本番環境でのモデルの性能を継続的に監視。入力データのドリフトなども検知可能。

- ※ ただし、試験対策では「ワークフロー自動化」や「デプロイ」に関連する問いに対しては正解とならない場合があります。

✅ 試験対策ポイントまとめ

| 観点 | 内容 |

|---|---|

| ✅ データ読み込み | TensorFlowならTensorFlow Data API、PyTorch・sklearnならBigQuery Storage API |

| ✅ ワークフロー自動化 | Vertex AI Pipelinesを活用して一貫したプロセス構築 |

| ⚠️ Feature Storeの誤用に注意 | 特徴量の保存には使うが、前処理やモデル保存には使わない |

| ⚠️ デプロイと保存は分けて考える | Predictionは推論用、Model Registryは保存・バージョン管理用 |

Vertex AI Workbench を用いた開発は、Google Cloudの機械学習エンジニア認定試験でも頻出のトピックです。上記のポイントを理解し、各サービスの役割と適切な使いどころを押さえておくことで、効率的なモデル開発と確実な試験対策が可能になります。